Spark是分布式计算平台,主要承担实验引擎发送过来的计算任务,包含Master和Worker两部分,其中Worker实例可以横向扩展。

提前部署Spark,为后续数据挖掘部署提供服务。

1、系统环境准备

注意:如果服务部署集群,集群内所有服务器均需设置系统环境。 |

1.1防火墙配置

为了便于安装,建议在安装前关闭防火墙。使用过程中,为了系统安全可以选择启用防火墙,但必须启用服务相关端口。

1.关闭防火墙

临时关闭防火墙

systemctl stop firewalld |

永久关闭防火墙

systemctl disable firewalld |

查看防火墙状态

systemctl status firewalld |

2.开启防火墙

相关服务及端口对照表:

| 服务名 | 需要开放端口 |

|---|---|

| Spark | 8080,8081,7077,[30000-65535] |

如果确实需要打开防火墙安装,需要给防火墙放开以下需要使用到的端口

开启端口:8080,8081,7077,[30000-65535]

firewall-cmd --zone=public --add-port=8080tcp --permanent firewall-cmd --zone=public --add-port=8081/tcp --permanent firewall-cmd --zone=public --add-port=7077/tcp --permanent firewall-cmd --zone=public --add-port=30000-65535/tcp --permanent |

配置完以后重新加载firewalld,使配置生效

firewall-cmd --reload |

查看防火墙的配置信息

firewall-cmd --list-all |

3.关闭selinux

临时关闭selinux,立即生效,不需要重启服务器。

setenforce 0 |

永久关闭selinux,修改完配置后需要重启服务器才能生效

sed -i 's/=enforcing/=disabled/g' /etc/selinux/config |

1.2 安装Java环境

安装包解压到/opt目录

tar -zxvf jdk8.0.202-linux_x64.tar.gz -C /opt |

配置java环境变量

①在/etc/profile 文件末尾添加,并保存

export JAVA_HOME=/opt/jdk8.0.202-linux_x64 export JRE_HOME=$JAVA_HOME/jre export CLASSPATH=.:$JAVA_HOME/lib:$JRE_HOME/jre/lib:$CLASSPATH export PATH=$JAVA_HOME/bin:$JRE_HOME/bin:$PATH |

②使配置生效

source /etc/profile |

③查看java版本信息

java -version |

2、Spark单机部署

1.修改主机名-添加映射关系

hostnamectl set-hostname 主机名 |

PS:主机名不能使用下划线

配置主机名和IP的映射关系

vi /etc/hosts |

内容设置,例如:

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4 ::1 localhost localhost.localdomain localhost6 localhost6.localdomain6 10.10.17.186 smartbi-spark |

2.设置系统免密登陆

生成密钥

ssh-keygen |

输入ssh-keygen后,连续按三次回车,不用输入其它信息

复制公钥

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys chmod 0600 ~/.ssh/authorized_keys |

测试是否设置成功,例如:

ssh root@smartbi-spark |

如果不用输入密码,表示成功。

3.安装Spark

解压spark安装包到指定目录

tar -zxvf spark-2.4.0-bin-hadoop2.7.tgz -C /opt |

4.启动Spark

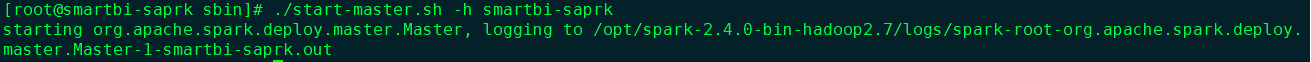

①启动Spark master

cd /opt/spark-2.4.0-bin-hadoop2.7/sbin ./start-master.sh -h 主机名 |

例如:主机名为smartbi-spark,则执行:

./start-master.sh -h smartbi-spark |

②启动Spark work

注意:参数 -c 为分配给spark work 节点的cpu核数,-m 为分配给spark work节点内存值

cd /opt/spark-2.4.0-bin-hadoop2.7/sbin ./start-slave.sh spark://master节点的主机名:7077 -c 配置的cpu数 -m xg 配置得的内存数(g为单位) |

Work 节点最低配置为 1 核 8G 内存。 cpu 和内存比值建议为 1:8 ,即一个 cpu 配置 8G 的内存 |

例如:worker节点为8核,64G内存的配置,master的主机名为smartbi-spark,2核16G留给系统跟hadoop,剩下的资源留给spark。则执行:

./start-slave.sh spark://smartbi-spark:7077 -c 6 -m 48g |

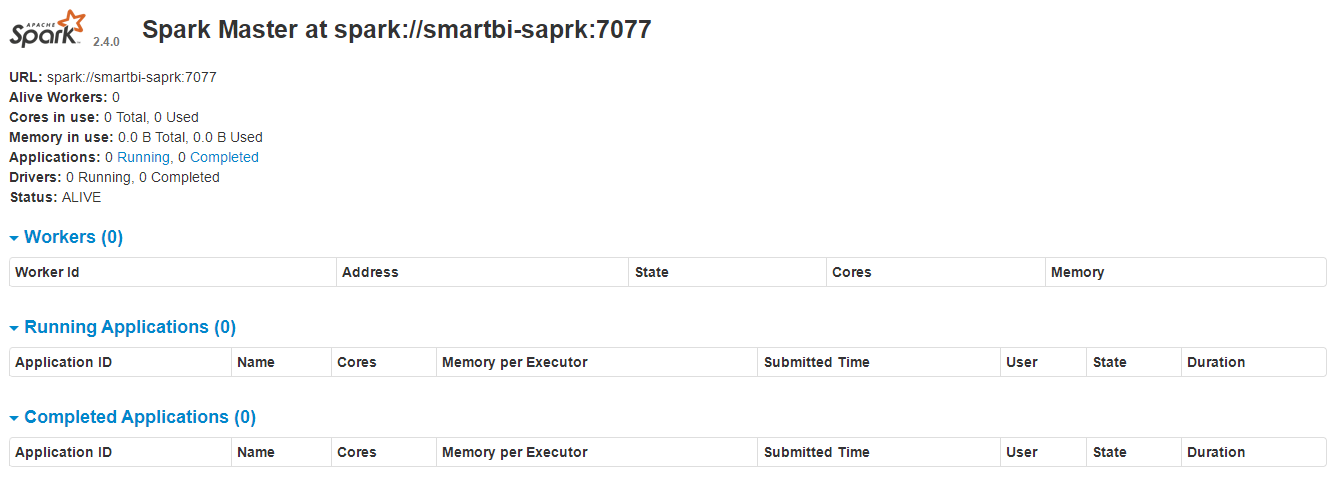

5.检查Spark

在浏览器中输入:http://master节点的ip:8080,查看集群状态

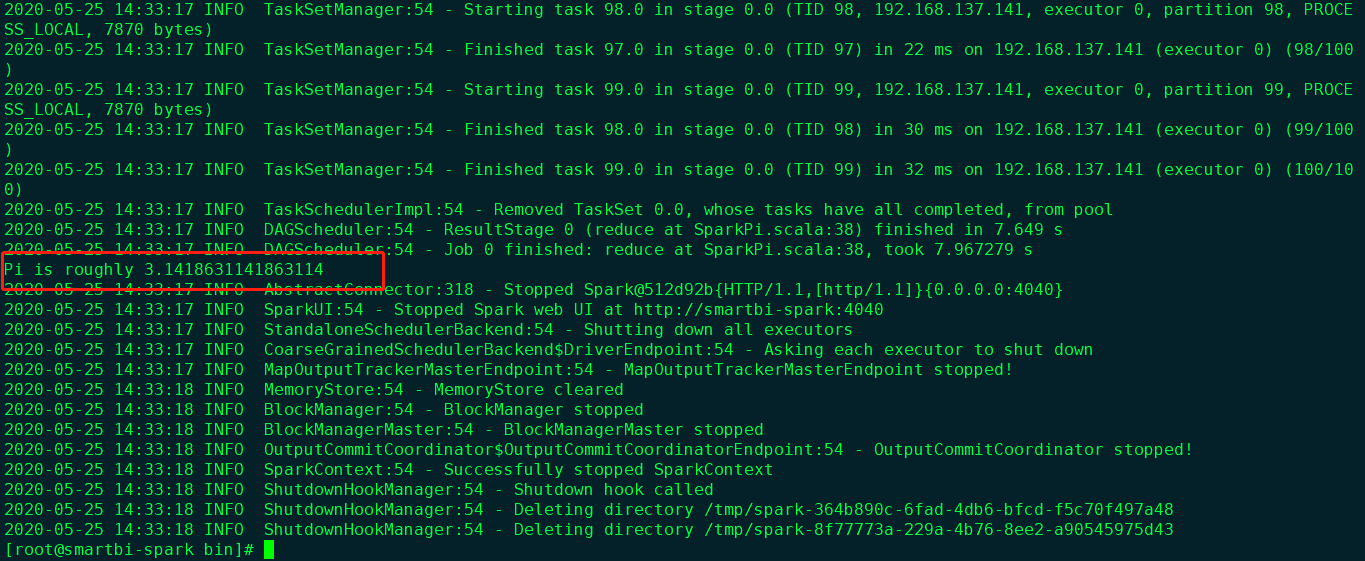

在master节点提交任务,执行以下命令(注意将”节点的IP”替换对应的IP或主机名)

cd /opt/spark-2.4.0-bin-hadoop2.7/bin ./spark-submit --class org.apache.spark.examples.SparkPi --master spark://节点的ip:7077 /opt/spark-2.4.0-bin-hadoop2.7/examples/jars/spark-examples_2.11-2.4.0.jar 100 |

运行得出圆周率Pi的近似值3.14即部署成功。

6.运维操作

停止Spark

cd /opt/spark-2.4.0-bin-hadoop2.7/sbin ./stop-all.sh |

启动Spark master

cd /opt/spark-2.4.0-bin-hadoop2.7/sbin ./start-master.sh -h 主机名 |

启动Spark worke

cd /opt/spark-2.4.0-bin-hadoop2.7/sbin ./start-slave.sh spark://master节点的主机名:7077 -c 配置的cpu数 -m xg 配置得的内存数(g为单位) |

查看日志

Spark的日志路径:/opt/spark-2.4.0-bin-hadoop2.7/logs

安装部署或者使用中有问题,可能需要根据日志来分析解决。

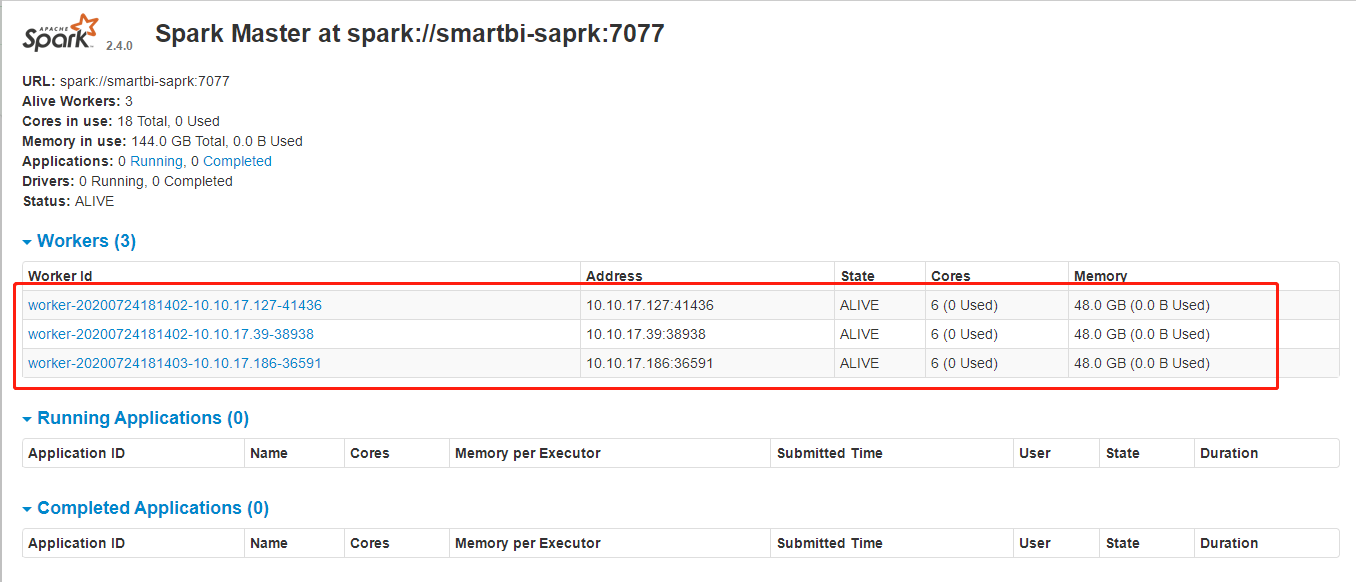

3、Spark集群部署

部署服务器:

| IP地址 | 主机名 | 角色 |

|---|---|---|

10.10.17.186 | smartbi-spark | Spark master,Spark work |

10.10.17.127 | smartbi-spark2 | Spark work |

10.10.17.39 | smartbi-spark3 | Spark work |

1.修改主机名-添加映射关系

hostnamectl set-hostname 主机名 |

PS:主机名不能使用下划线

配置主机名和IP的映射关系

vi /etc/hosts |

内容设置,例如:

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4 ::1 localhost localhost.localdomain localhost6 localhost6.localdomain6 10.10.17.186 smartbi-spark 10.10.17.127 smartbi-spark2 10.10.17.39 smartbi-spark3 |

2.设置系统免密登陆

生成密钥

ssh-keygen |

输入ssh-keygen后,连续按三次回车,不用输入其它信息

复制公钥

ssh-copy-id -i ~/.ssh/id_rsa.pub root@smartbi-spark ssh-copy-id -i ~/.ssh/id_rsa.pub root@smartbi-spark2 ssh-copy-id -i ~/.ssh/id_rsa.pub root@smartbi-spark3 |

如果以上命令执行失败,可以手动把每个节点 ~/.ssh/id_rsa.pub的数据追加到其它节点的~/.ssh/authorized_keys文件中, 如果~/.ssh/authorized_keys不存在,可以新建一个.

测试是否设置成功,例如:

ssh root@smartbi-spark ssh root@smartbi-spark2 ssh root@smartbi-spark3 |

如果不用输入密码,表示成功。

3.Spark master节点安装Spark

①解压spark安装包到指定目录

tar -zxvf spark-2.4.0-bin-hadoop2.7.tgz -C /opt |

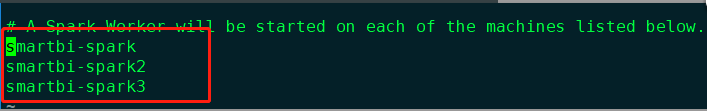

②配置Spark从节点列表

cd /opt/spark-2.4.0-bin-hadoop2.7/conf cp slaves.template slaves vi slaves |

把所有spark worker节点的机器名加到slaves文件中,例如slaves文件内容设置如下:

smartbi-spark smartbi-spark2 smartbi-spark3 |

③配置Spark-env

cd /opt/spark-2.4.0-bin-hadoop2.7/conf cp spark-env.sh.template spark-env.sh |

例如:worker节点为6核,48g内存,把2核16G留给操作系统

内容设置如下:

JAVA_HOME=/opt/jdk8.0.202-linux_x64 SPARK_MASTER_IP=smartbi-spark SPARK_MASTER_PORT=7077 SPARK_MASTER_WEBUI_PORT=8080 SPARK_WORKER_CORES=6 SPARK_WORKER_MEMORY=48g |

JAVA_HOME=java安装路径 SPARK_MASTER_IP=spark的管理节点主机名或ip SPARK_MASTER_PORT=7077 #spark master监听端口 SPARK_MASTER_WEBUI_PORT=8080 #sparkmaster web监听端口 SPARK_WORKER_CORES=worker进程cpu数量(视现场服务器配置而定) SPARK_WORKER_MEMORY=worker进程可支配内存(视现场服务器配置而定,单位:G, 例如:2G ) |

4.Spark安装包分发到集群其他节点

将Spark安装包分发到其他节点:

scp -r /opt/spark-2.4.0-bin-hadoop2.7 root@smartbi-spark2:/opt scp -r /opt/spark-2.4.0-bin-hadoop2.7 root@smartbi-spark3:/opt |

5.启动Spark集群

登陆Spark master主机节点启动Spark集群

cd /opt/spark-2.4.0-bin-hadoop2.7/sbin/ ./start-all.sh |

6.检查spark集群

在浏览器中输入:http://master节点的ip:8080,查看集群状态

显示Spark集群中的所有work节点,表示spark集群安装完成。

7.运维操作

停止Spark集群,登陆Spark master节点操作:

cd /opt/spark-2.4.0-bin-hadoop2.7/sbin #./stop-all.sh |

启动Spark集群,登陆Spark master节点操作:

cd /opt/spark-2.4.0-bin-hadoop2.7/sbin/ ./start-all.sh |

查看日志

Spark的日志路径:/opt/spark-2.4.0-bin-hadoop2.7/logs

安装部署或者使用中有问题,可能需要根据日志来分析解决。