本节介绍smartbi连接数据挖掘实验、服务引擎和Python计算机点以及测试服务是否正常运行。

测试数据挖掘及组件

1.检查smartbi连接数据挖掘引擎配置

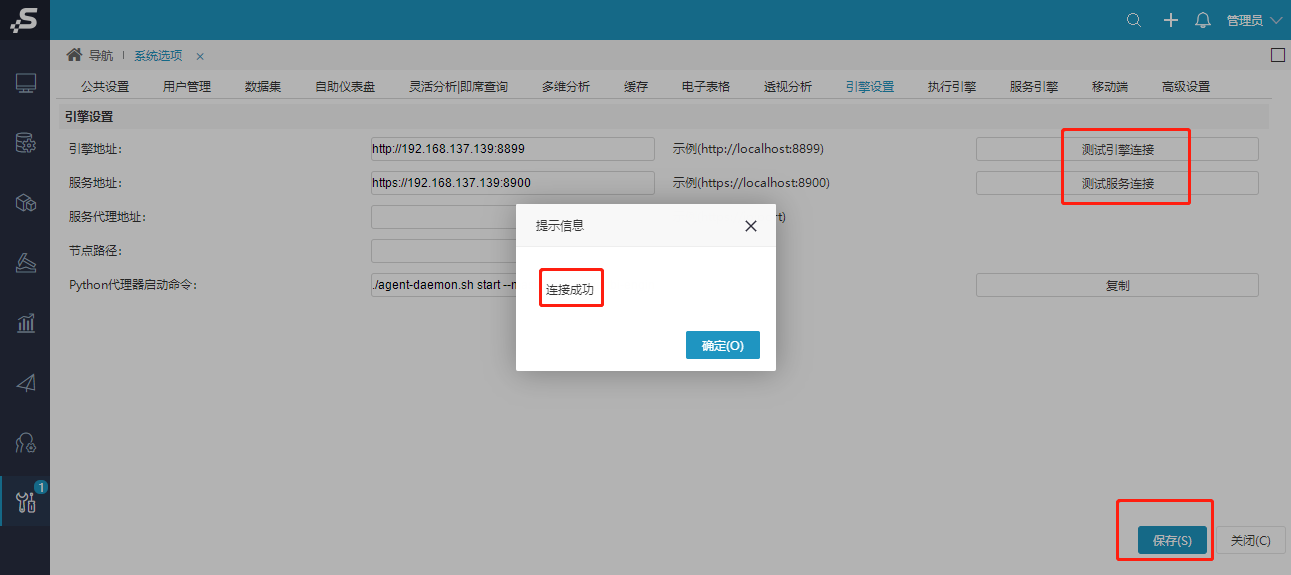

①登录smartbi,检查当前连接的数据挖掘引擎配置

系统运维--系统选项—引擎设置,如图所示,实验引擎和服务引擎连接地址无误后,点击测试连接,均能提示连接成功。

②系统运维–系统选项–执行引擎–引擎配置,检查配置,确认连接信息

引擎和服务所在的主机名不能带有小数点或下划线。

③系统运维–系统选项–执行引擎–计算节点,检查配置,确认连接信息

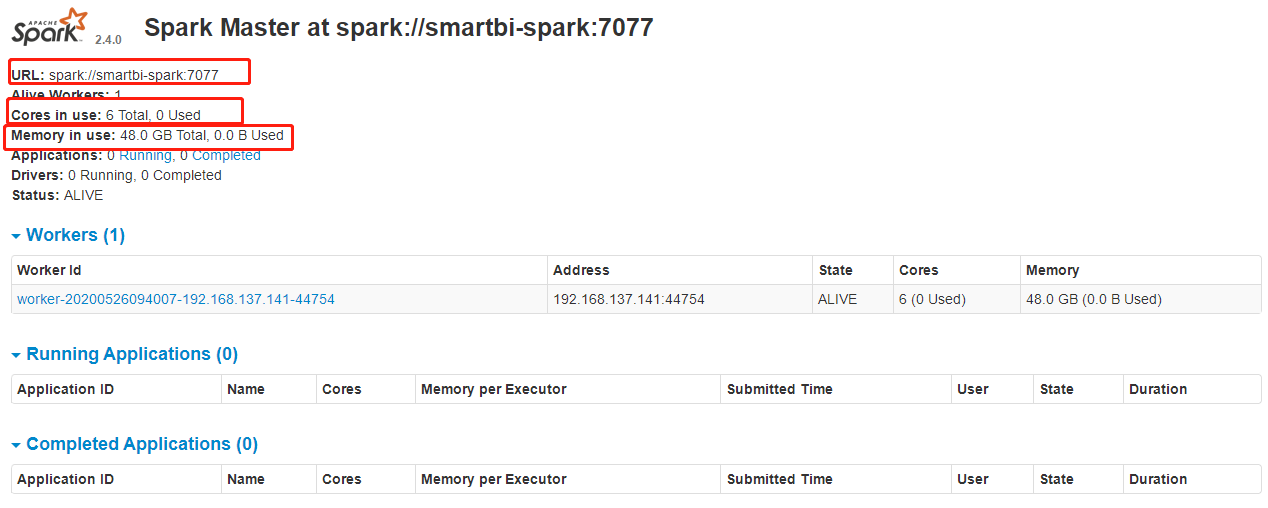

浏览器访问spark master webui, 访问地址:http://sparkmaster安装机器ip:8080, 比如spark master安装在192.168.137.141机器,那访问地址就是: http://192.168.137.141:8080

访问后,显示如下,第一个框是指spark master连接地址,第二个框是指spark可分配的cpu核数,第三个框指spark可分配的内存数。

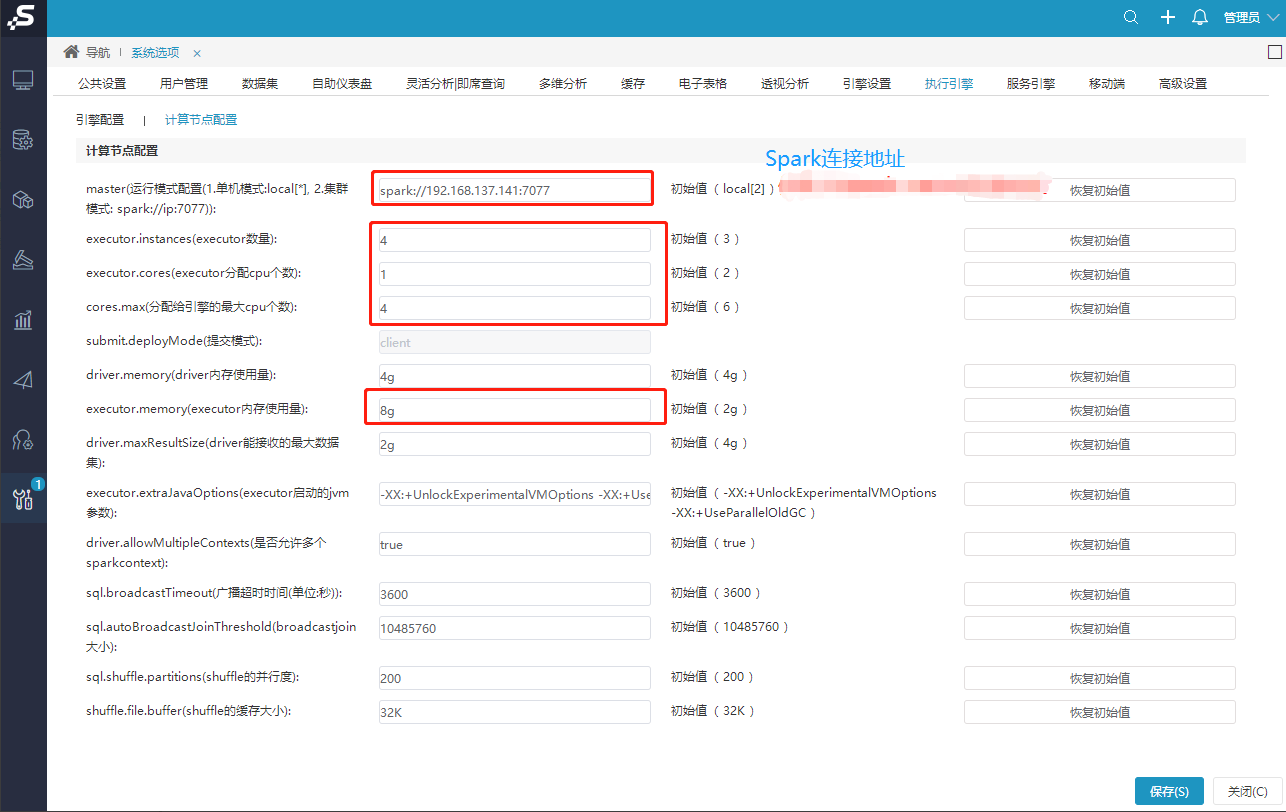

系统运维—系统选项—执行引擎—计算节点配置

如下图所示,重点配置红框地方,第一个框填写spark master连接地址,其它选项配置策略推荐如下(某种场景下,这并不是最优策略,可根据实际情况调整):

Spark配置解析

1.executor.instances * executor.memory <= spark可分配的内存数 * 0.75(例如上图: 48G * 0.75 = 36)

2.executor.instances * executor.cores <= spark可分配的cpu核数 * 0.75(例如上图: 6核 * 0.75 = 4)

3.cores.max = executor.instances * executor.cores

默认情况下,executor.memory 配置为8G,除非总的内存比8G还小,根据上面策略,其它选项配置如下

executor.instances = spark可分配的内存数 * 0.75 / executor.memory = 48 * 0.75 / 8 = 4

executor.cores = spark可分配的cpu核数 * 0.75 / executor.instances = 6 * 0.75 / 4 = 1

cores.max = executor.instances * executor.cores = 4 * 1 = 4

给引擎分配的cpu个数、内存大小,不能超过spark服务器拥有的cpu个数、总内存的大小,否则引擎会启动失败。

④系统运维–系统选项–服务引擎,检查配置,确认连接信息

2.测试数据挖掘实验引擎

1)登陆smartbi,打开数据挖掘-案例-选择一个案例,打开。

2)保存数据挖掘实验,运行数据挖掘,运行成功即数据挖掘实验部署成功。

3.测试数据挖掘服务引擎

1)打开数据挖掘-案例-波士顿房价预测。

2)保存示例,点击运行,等待运行成功。

3)右键点击”训练”-模板-保存模型。

4)保存的的模型可以在左侧导航栏的”已训练模型”中查看。右键删除”随机森林”,”训练”。

5)将保存的示例模型拖入,并与”预测连线”。

6)导航栏-服务-拖入 服务输入、服务输出,并连线,运行成功后点击部署服务。

7)服务部署成功后选择服务测试,显示测试结果。

Smartbi-Engine-Service部署测试成功。

4.测试数据挖掘服务引擎-Python计算节点

1)打开 数据挖掘 > 新建实验 。

2)拖拽“示例数据源”,选择数据源 - 保存 - 运行 - 运行成功

3)拖拽PYTHON脚本,与示例数据源连线,点击Python脚本。

4)点击确定。

5)点击运行,提示运行成功,则Python计算节点部署成功。